Veelgestelde vragen over Microsoft 365 Copilot en de DPIA-uitkomsten

De DPIA op Microsoft 365 Copilot is afgerond. Op deze pagina vind je een selectie van de veelgestelde vragen en antwoorden over Microsoft 365 Copilot en de DPIA. Via de blauwe knop hieronder ga je naar het pdf-document met alle vragen en antwoorden.

Let op: dit is momenteel ook alle informatie die onze Servicedesk beschikbaar heeft.

Beschikbaarheid en advies

Microsoft 365 Copilot komt in de week van 6 januari 2025 beschikbaar in de webwinkels van APS IT-diensten, SLBdiensten en SURF. Vanaf dat moment zijn de prijzen bekend. Je bent hoge kortingen gewend bij APS IT-diensten, maar die zullen bij Microsoft 365 Copilot lager zijn omdat het gebruik van AI hoge kosten met zich meebrengt.

Een gunstigere prijs is wellicht mogelijk als we een harde financiële toezegging afgeven, gebaseerd op volumeafname. Gezien de DPIA-resultaten kunnen wij die toezegging op dit moment niet doen. Maar als dit wel mogelijk is, zullen we zeker kijken of we collectief een gunstigere prijs kunnen krijgen.

Wij geven vooralsnog een negatief advies op het gebruik van Microsoft 365 Copilot. Maar het is niet verboden Microsoft 365 Copilot te gebruiken. Het is aan jouw schoolbestuur om te beslissen of je er wel of niet mee aan de slag gaat, eventueel in combinatie met nemen van maatregelen die de risico’s verkleinen en/of een risicoacceptatie.

De DPIA

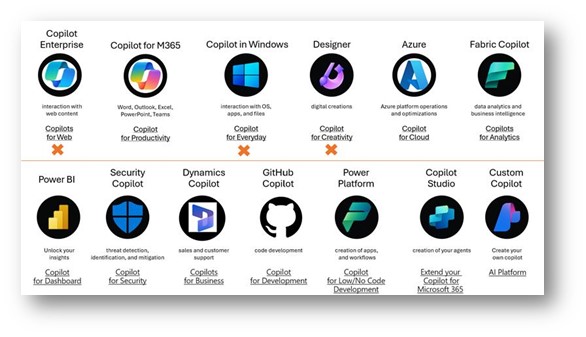

Microsoft gebruikt het woord Copilot in combinatie met veel producten. Hieronder vind je een overzicht van alle Copilots. Een oranje X betekent dat het product niet valt onder de privacyvoorwaarden van onze overeenkomst met Microsoft of niet beschikbaar is via onze overeenkomst.

De DPIA die in 2024 is uitgevoerd, gaat over Microsoft 365 Copilot (2e van linksboven, let op: in het overzicht staat de oude naam). Dit is de variant die beschikbaar is in allerlei Microsoft 365-applicaties, zoals Word, Teams en PowerPoint. Inmiddels is Copilot Studio ook onderdeel van deze licentie.

Ja, Copilot Studio (voorheen Power Virtual Agents) is inmiddels onderdeel van Microsoft 365 Copilot en dus ook meegenomen in de DPIA.

Ja, de bevindingen en adviezen gelden voor ook voor:

- de consumentenversie van Copilot in de Edge-browser (voorheen Bing Chat)

- Copilot Enterprise, de variant voor Entra ID gebruikers (Bing Chat met dataprotectie)

Zie hieronder de verschillen tussen deze ‘gratis’ Copilot-versies en Microsoft 365 Copilot. Let op: in januari 2025 zal Microsoft Copilot (de twee varianten links) een nieuwe naam krijgen: Microsoft 365 Copilot Chat.

In de uitgebreide DPIA van SURF staan een aantal stappen hiervoor (zie pagina 112), maar deze gaan over de gratis variant en niet de Enterprise-variant voor scholen. De Copilot Chat zit zo verweven in de Microsoft 365-omgeving waardoor het vrij lastig is om deze functionaliteit uit te zetten. In Windows 11 versie 24H2 is Copilot een standaard onderdeel en vanaf januari 2025 zal de term ‘Microsoft 365 apps’ vervangen worden door ‘Microsoft 365 Copilot’. Zo zal iedereen steeds meer AI-ervaringen ‘verplicht’ ontvangen. Ons advies is daarom om medewerkers goed bewust te maken van de risico’s van AI en hen te trainen in veilig gebruik.

Risico’s en maatregelen

Ja, denk hierbij aan:

- Begin kleinschalig en besteed aandacht aan training: Copilot vraagt om een sterke leercurve van de gebruiker. Denk daarom goed na over de use-cases waar je eerst kleine groepen mee laat experimenteren. Wees hierbij voorzichtig met gevoelige data. Daarnaast is de kans op een (data)lek groter wanneer je Microsoft 365 Copilot direct grootschalig gaat uitrollen.

- Zorg voor een veilige inrichting: kijk vooraf goed naar je inrichting, rollen en rechten, want verkeerde toegang tot (gevoelige) data komt met behulp van Copilot veel sneller boven water.

- Optimaliseer het documentbeheer: Microsoft 365 Copilot werkt efficiënter als iedereen in dezelfde SharePoint-mappen werkt. Bestanden in persoonlijke OneDrives worden niet gevonden door andere collega's. Maak dus goede afspraken over de plaats waar documenten worden opgeslagen.

- Copilot securityscan: voer vooraf een securityscan uit om mogelijke risico’s bij het inschakelen van Microsoft 365 Copilot in kaart te brengen. Beslis welke maatregelen je hiervan vooraf wilt implementeren, dus vóórdat je Microsoft 365 Copilot gaat gebruiken.

Generatieve AI is in feite kansberekening op de volgorde van woorden. De uitkomsten zijn dus niet per definitie juist en een onjuiste uitkomst over personen kan die betreffende personen beschadigen. Dit probleem speelt bij alle generatieve AI en dus niet specifiek bij Copilot.

Je kunt het risico verkleinen door je collega’s goed te trainen in het gebruik van AI. Zij moeten leren om de uitkomsten van AI altijd kritisch te evalueren en niet zomaar als waar aan te nemen. Ook als er geen persoonsgegevens bij betrokken zijn.

Aan de technische kant zullen leveranciers, in dit geval Microsoft, ook maatregelen moeten nemen. Zij moeten ervoor zorgen dat bronvermeldingen altijd kloppen, en de Large Language Modellen zo trainen dat deze zo min mogelijk onjuiste uitkomsten geven.

Microsoft 365 Copilot vergeleken met andere AI-tools

SURF heeft alleen een DPIA op Microsoft 365 Copilot uitgevoerd. We kunnen daarom geen uitspraken over andere leveranciers doen. Er moeten dan DPIA’s op al die toepassingen uitgevoerd worden, in plaats van alleen op Microsoft 365 Copilot. Mogelijk kunnen we daar samen met SURF en SIVON een rol in spelen. Wel is het tweede hoge risico uit de DPIA (het generen van onjuiste en/of incomplete persoonsgegevens) eigen aan generatieve AI. Dit risico zal zich hoogstwaarschijnlijk ook bij oplossingen van andere leveranciers voordoen.